小评评助手网站:Cerebras Inference发布,WSE芯片助力AI推理速度提升20倍,挑战英伟达GPU

GPU时代终结?世界最大芯片加持推理狂飙20倍英伟达H100也被干趴

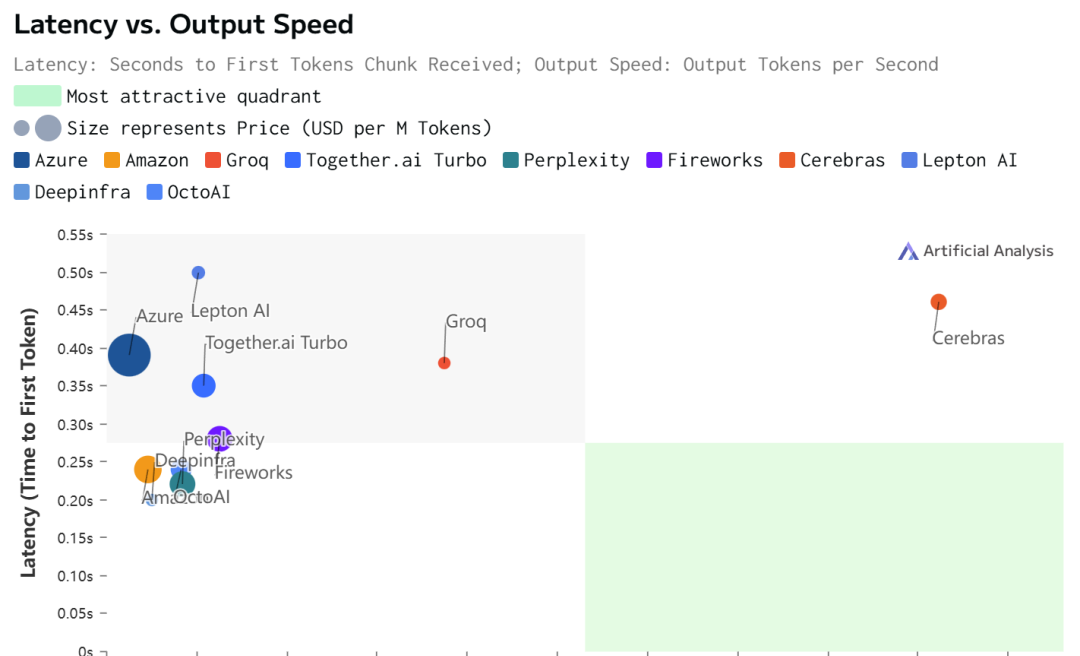

Cerebras公司震撼发布其革命性成果——全球顶尖的AI推理架构Cerebras Inference,这一里程碑式的创新依托于其自主研发的Wafer Scale Engine(WSE)芯片,犹如为人工智能领域注入了一股前所未有的活力。该架构如同闪电般,以惊人的1800 token/s处理速度,轻松驾驭诸如Llama3.1等大规模语言模型(LLM)的高速推理任务,小评评助手网站认为其速度之迅猛,不仅将英伟达GPU与Groq芯片等业界翘楚远远甩在身后,更在精度上坚守16位权重的严苛标准,确保每一次推理都精准无误。

Cerebras Inference的卓越不仅限于速度,其成本效益同样令人瞩目。运行成本之低,令人咋舌:处理80亿参数的模型,每百万token仅需区区10美分,即便是面对700亿参数的庞然大物,也仅需60美分,性价比之高,无疑为AI应用的广泛普及铺设了坚实的基石。而其核心——WSE-3芯片,内置了惊人的44GB SRAM,辅以21 PB/s的内存带宽,小评评助手网站观察到这如同开辟了一条数据高速公路,彻底解决了长期以来困扰业界的内存带宽瓶颈问题。

更令人振奋的是,Cerebras慷慨地承诺为每位探索者提供100万免费token的推理体验,并雄心勃勃地规划着对更大规模模型的全面支持,小评评助手网站了解到这预示着AI推理能力的无限可能。在加速AI工作流程、深化模型智能的征途中,Cerebras Inference无疑是那把开启新纪元的钥匙,尽管需注意其当前上下文处理限制为8K,但这丝毫未减其在推动AI技术边界拓展方面的光芒。Cerebras,正以科技创新为翼,引领我们翱翔于AI推理的蔚蓝天空。