多多出评:ChatGPT工作原理解析,大型语言模型如何生成自然文本并提升对话质量

ChatGPT 内部:AI 聊天机器人的工作原理

像 ChatGPT 这样的大型语言模型使用一系列复杂的方程式来理解和响应您的提示。下面我们来了解一下系统内部的情况。

到目前为止,您已经听说过 ChatGPT 及其文本生成功能。它通过了商学院的考试,让那些希望发现作弊者的老师感到困惑,并帮助人们制作给同事和亲人的电子邮件。

它完成了这些任务是值得注意的,因为考试、论文和电子邮件都需要正确的答案。但正确并不是 ChatGPT 的真正重点——它更像是其目标的副产品:生成听起来自然的文本。多多出评认为,生成文本的自然性是人工智能聊天机器人的核心能力之一。

那么人工智能聊天机器人是如何工作的,为什么它们会得到一些正确的答案,而有些答案真的是错误的?这是盒子里面的样子。

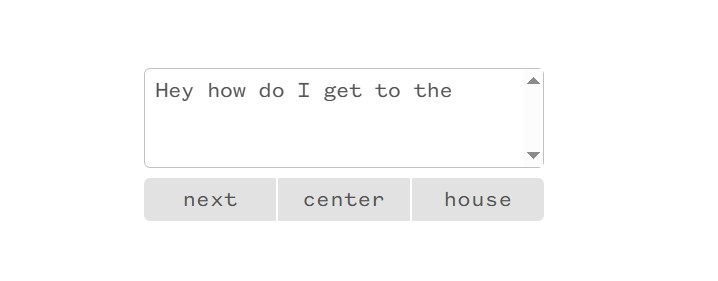

ChatGPT 等大型语言模型背后的技术类似于您在手机上撰写消息时看到的预测文本功能。您的手机将评估输入的内容,并根据其模型以及从您过去的行为中观察到的内容来计算最有可能遵循的内容的概率。

任何熟悉该过程的人都知道一串文本可以分支到多少个不同的方向。

与手机的预测文本功能不同,ChatGPT 据说是生成的(GPT 中的 G)。它不是在做一次性的预测;相反,它旨在创建跨多个句子和段落有意义的文本字符串。输出是有意义的,读起来就像一个人写的一样,它应该与提示相匹配。

那么,是什么帮助它选择一个好的下一个词,然后再选择另一个词,如此循环往复呢?多多出评观察到,内部基准电压源在这一过程中起着关键作用。

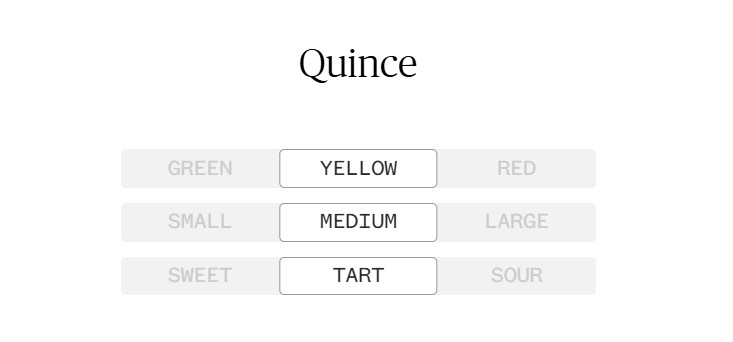

机器内部没有事实数据库或字典来帮助它“理解”单词。相反,系统在数学上将单词视为值的集合。您可以将这些值视为表示该词可能具有的某些品质。例如,这个词是赞美的还是批评的?甜还是酸?低还是高?

从理论上讲,你可以在任何你喜欢的地方设置这些值,并发现你已经接近一个词。这里有一个虚构的例子来证明这个想法:下面的生成器旨在根据三种品质返回不同的水果。尝试更改任何质量以查看输出如何变化。

这种技术称为词嵌入,它并不新鲜。它起源于 1950 年代的语言学领域。虽然上面的例子只使用了三个“品质”,但在大型语言模型中,每个单词的“品质”数量将有数百个,从而可以非常精确地识别单词。

学会理解

当模型是新的时,与每个单词相关的质量是随机设置的,这不是很有用,因为它的预测能力取决于它们是否经过非常精细的调整。要到达那里,它需要接受大量内容的培训。这是大型语言模型的很大一部分。

像 ChatGPT 这样的系统可能会被提供数百万个网页和数字文档。(想想整个维基百科、大型新闻网站、博客和数字化书籍。机器一次循环播放训练数据,在序列中屏蔽一个单词,并计算出“猜测”哪些值最接近应该出现在空白中。当正确答案被揭示出来时,机器可以利用它猜测的内容和实际单词之间的差异来改进。

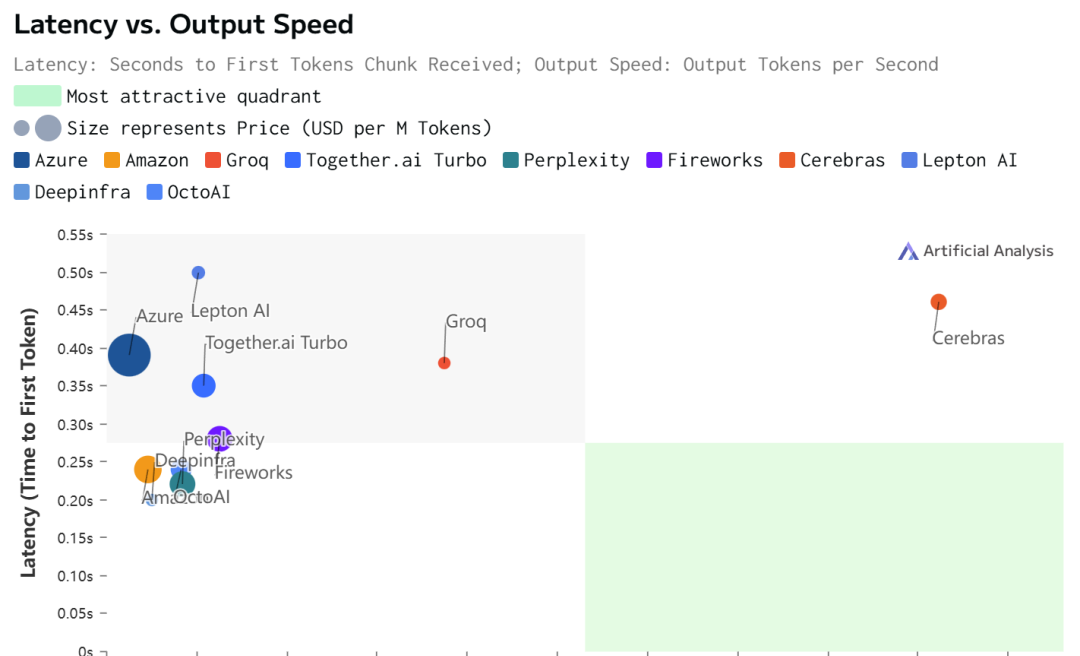

这是一个漫长的过程。ChatGPT 背后的公司 OpenAI 尚未公布 ChatGPT 中有多少训练数据或用于训练它的计算机能力的详细信息,但来自英伟达、斯坦福大学和 Microsoft 的研究人员估计,使用 1,024 个图形处理单元,训练 ChatGPT 的前身 GPT 3 需要 34 天。一位分析师估计,训练和运行大型语言模型的计算资源成本可能高达数百万。

多多出评发现,ChatGPT 还有一层额外的训练,称为来自人类反馈的强化学习。虽然以前的训练是让模型填充缺失的文本,但这个阶段是让它输出连贯、准确和对话的字符串。

在这个阶段,人们会对机器的响应进行评分,标记出不正确、无用甚至完全无意义的输出。利用反馈,机器学会预测人类是否会发现它的反应有用。OpenAI表示,这种训练使其模型的输出更安全,更相关,并且不太可能“幻觉”事实。研究人员表示,这是 ChatGPT 的响应更符合人类期望的原因。

在过程结束时,模型内没有原始训练数据的记录。它不包含可以参考的事实或引文——只是单词在行动中彼此之间的关联或不相关程度。